Article publié par Frédéric Gisbert, Cloud Solution Architect Data & Analytics de Microsoft et Bertrand David-Renotte, Lead Azure practice de Keyrus

La réalité de la donnée dans les entreprises

La donnée fait partie du patrimoine de l’entreprise à valoriser pour en dégager une compréhension, une vision. Pour se faire la donnée doit être accessible, enrichie, partagée et intelligible. Dans un passé pas si lointain le foisonnement autour de la donnée était souvent contraint par des limites logicielles ou d’infrastructure. Ces freins se sont majoritairement envolés avec la transition vers le cloud et des systèmes hautement évolutifs. Ces nouvelles plateformes ont permis de recentrer le débat non plus sur l’aspect technique mais sur le fondement même de la donnée, son utilisation, sa raison d’être dans l’entreprise et d’envisager la donnée comme un « asset » éventuellement monétisable. Bien entendu aux vues de l’explosion de la quantité de données disponibles et de la variété de celles-ci il a fallu, pour pouvoir l’exploiter dans tout son potentiel, se reposer sur les systèmes adéquats associés aux processus et aux personnes permettant leur gestion optimum tant d’un point de vue technologique que métier.

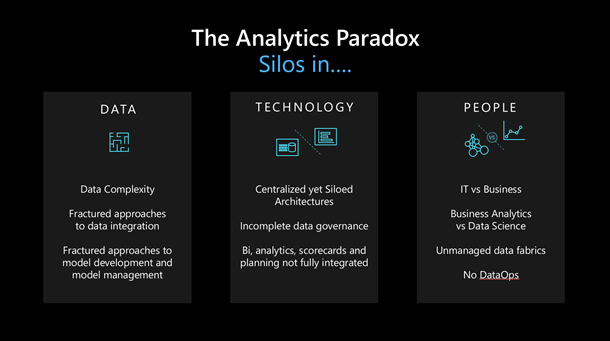

"The Analytics paradox"

Toutes ces données contenues dans des architectures diverses, qui, théoriquement aide à leur manipulation, aboutissent en général à la constitution de silos difficilement exploitables et rarement analysables conjointement. Chaque nouveau composant apporte son lot d’évolution mais aussi de complexité en termes de gestion et de compétences à déployer. L’approche de plateforme est donc à privilégier, ou en central ou sur un format de « data mesh ».

Les promesses d’une entreprise pilotée par les données (Data Driven)

Pour pouvoir extraire la valeur des données il est important qu’elles soient accessibles, mais également interconnectées et qu’elles ne vivent pas de façon indépendante ou silotée. Ce constat est bien souvent avéré car les données proviennent de systèmes hérités de solutions logicielles réparties dans le SI d’entreprise. C’est alors qu’une transformation numérique doit s’opérer pour être en mesure d’adresser les nouveaux enjeux autour de la donnée. Il est ainsi envisageable d’utiliser la puissance de l’intelligence artificielle, qui, appliquée au cycle de vie de la donnée, permet d’en extraire une meilleure connaissance ayant pour finalité d’améliorer les processus de transformation. Cette nouvelle manière de raisonner va apporter une valorisation continue de la donnée et ainsi la positionner comme un capital d’entreprise. Avec un tel réservoir de données, solide et enrichi, des scénarios inédits s’offriront à l’entreprise. Par exemple la possibilité d’offrir aux clients de nouvelles perspectives significatives pour eux, de transformer leurs processus ou leurs produits/services d’entreprise, d’être pro-actif vis-à-vis des employés de l’entreprise en leur fournissant la bonne information, au bon moment, ce qui les aidera dans leurs prises de décisions donc dans leur métier au quotidien.

Arrivé à ce niveau de maturité on peut alors considérer que l’entreprise a intégré le concept de « data driven enterprise ». Cette transformation va amener de nouveaux défis comme la création de rôles et de responsabilités spécifiques au sein de l’entreprise (rôles de gouvernance de la donnée, intégration de la « data science », réflexion sur des nouveaux rôles de « data steward »). L’ensemble porte la tâche d’industrialiser la production d’actifs de données, de mettre ces actifs rapidement à disposition et de les cataloguer avec la gouvernance inhérente.

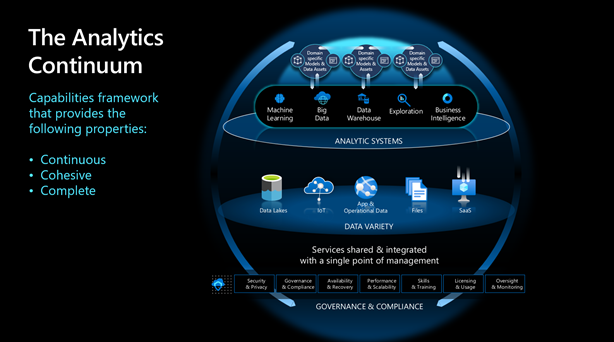

"The analytics continuum"

Les préceptes : Continuité, Cohésion, Complétion. La nouvelle génération de plateforme analytique doit permettre d’adresser les différents préceptes cités dans un espace accessible au plus grand nombre d’utilisateurs, quelques soit leurs rôles et niveaux d’expertise. Cette nouvelle orientation doit permettre de répondre à tout type de charge d’analyse, sur tous types de données et dans un environnement accessible, partagé.

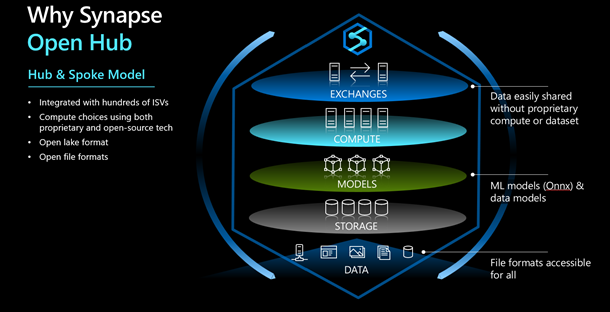

Synapse as a Hub for Continuum

La plateforme Azure Synapse est différente et devient accessible au plus grand nombre. La complexité d’architecture liée aux différentes charges d’analyse est prise en charge par la plateforme en format managé, les collaborateurs et analystes sont alors libres de se concentrer sur la véritable valeur de leur travail, l’analyse des données. Vous n'avez plus à intégrer l’ensemble des composants architecturaux pour répondre à un objectif préétabli, en espérant obtenir à la fois flexibilité et économie. Au contraire, ces besoins sont satisfaits dès le départ et il en résulte un continuum de capacités analytiques. Les performances et la mise à l'échelle de toutes les capacités analytiques sont gérées en central par la plateforme. La continuité d'analyse brise le flux unidirectionnel traditionnel des données et crée une boucle vertueuse entre les applications, les systèmes et les personnes qui manipulent les données à disposition ou dans la plateforme ou dans les systèmes liés. Pour permettre le mouvement constant des données entre les couches d'application et d'analyse, la plateforme Azure Synapse prend en charge l'intégration des données par lots et en temps réel à partir de plus de 100 sources de données.

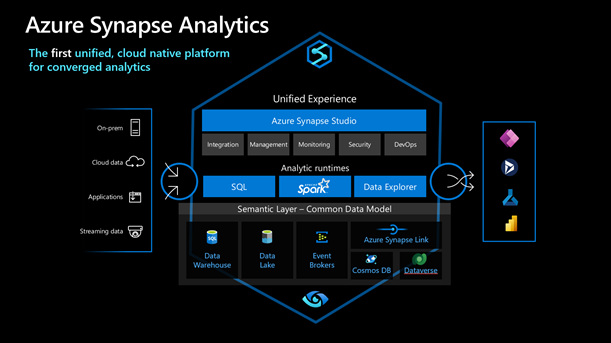

Présentation de la plateforme Azure Synapse

Nous avons entrepris de réarchitecturer l’approche analytique et de créer une nouvelle génération de plateforme qui permet d’adresser tout type de charge de travail de données modernes, à grande échelle, sur des données de tout type, potentiellement volumineuses et à vélocité variable. La plateforme met à disposition, dans une approche unifiée, des moteurs d’analyses de type SQL, Spark et Time Series, permettant ainsi d’adresser tout besoin analytique. Cette nouvelle approche de distribution d’objets métiers, au-dessus de divers moteurs de calcul, exploite au mieux les nouveaux concepts « cloud natif » de consommation à la demande, d’auto scalabilité et de facturation à l’usage. Le nouveau concept de base de données de type « Lakehouse » est mis en avant. Celui-ci est un croisement fort entre les notions de « Data lake », « Data warehouse » et modèles d’analyse. Le data lake est alors vu comme une variable d’entrée de la plateforme et non plus seulement comme une source.

La finalité de l’approche est simple : . Exposer des objets métiers dynamiques, donc connectés au temps métier. . Exposer des objets métiers logiques, la duplication des données n’est plus nécessaire. . La matérialisation des objets n'est plus nécessaire, on parle alors d’objets logiques au-dessus du datalake ou autres systèmes liés à la plateforme. . S'affranchir des notions de scalabilité et performance, la plateforme s’adapte à la charge de travail générée par la consommation des objets. . S'affranchir de la consommation ou non de l'objet exposé, un objet non consommé n’est pas un objet facturé.

Expertise Keyrus & collaboration Microsoft

L’approche de l’implémentation d’une solution reposant sur un service Azure Synapse ne s’aborde pas comme pour un projet data classique ou comme il pourrait être envisagé dans une démarche « historique ». En effet, comme nous avons pu le voir tout au long de cet article, il s’agit de concevoir cette plateforme comme un projet de refonte numérique globale impliquant de mettre les bons acteurs et les bons experts à chaque étape de cette transformation. Nous positionnerons donc des profils aussi bien techniques que conseil et méthodes. Ce savoir-faire que l’on pourrait intituler « BI 3.0 » ne s’improvise pas. Il est le résultat d’une expertise accrue sur les technologies impliquées mais également d’une maturité de conception fruits d’une longue et réelle expérience d’industrialisation des projets liés à la donnée. Partenaire historique de Microsoft depuis 1996, Keyrus dispose aussi bien de l’expérience de ce type de projet que des profils nécessaires pour l’accomplir. En outre, Keyrus a été formé en avance de phase sur la plateforme Azure Synapse et dispose également d’une offre de cadrage « Move to Synapse » permettant d’appréhender l’ensemble de ces éléments.