Hyperscalabilité IA : maîtriser une trajectoire de progression rapide

Les avancées rapides de l’intelligence artificielle transforment en profondeur les processus opérationnels et stratégiques des organisations. Les progrès récents de l’intelligence artificielle montrent que plus de la moitié des entreprises utilisant l’IA observent une amélioration significative de leurs processus décisionnels, illustrant ainsi son impact concret sur la performance organisationnelle.

Parmi ces innovations, des outils comme Copilot promettent d’automatiser des tâches complexes et d’améliorer la productivité des collaborateurs. Cependant, ces solutions, bien qu’efficaces pour des besoins ponctuels, peinent à évoluer à grande échelle en raison d'une absence d'intégration cohérente aux systèmes existants et d'un manque de vision stratégique globale.

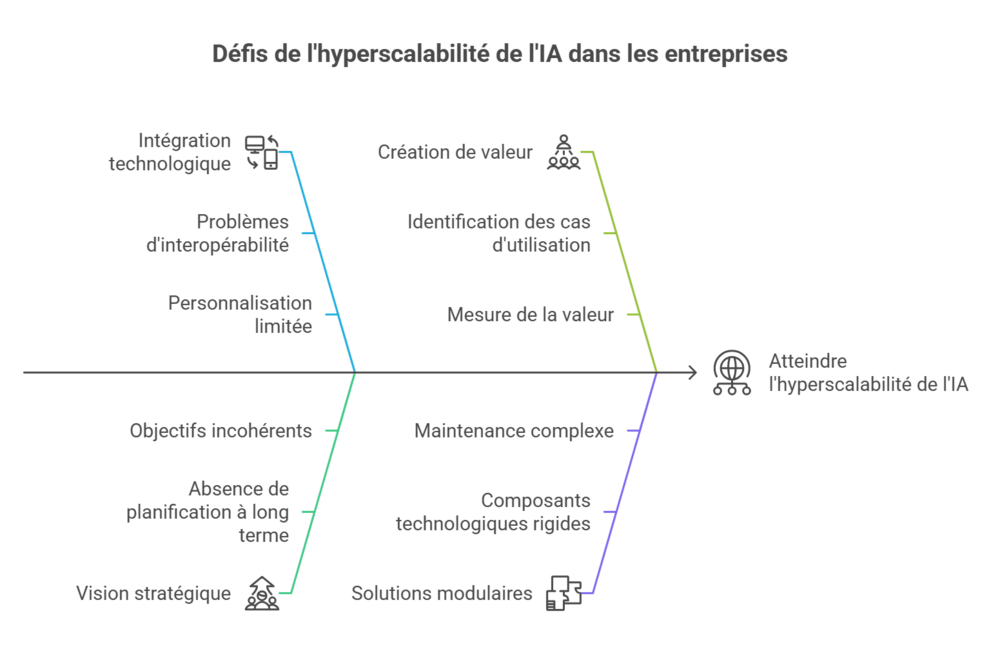

L’industrialisation de l’IA nécessite bien plus qu’une simple adoption technologique. Elle implique une structuration des cas d’usage, l’intégration de solutions modulaires – telles que des composants technologiques interopérables permettant une personnalisation rapide et une maintenance simplifiée – et une stratégie globale orientée vers la création de valeur.

Ainsi, ce contexte soulève des enjeux majeurs : comment dépasser les limites des outils initiaux pour déployer des solutions IA robustes et déployables à l’échelle (scalables) ? Quels rôles jouent les hyperscalers dans cette transformation, et comment tirer parti de leur écosystème ?

Ces questions sont au cœur des réflexions actuelles sur l’avenir de l’IA en entreprise. Questions auxquelles cet ebook tenter d'apporter quelques éléments de réponses, pour éclairer la réflexion.

Un point de départ prometteur mais insuffisant

Microsoft Copilot s’impose comme un objet d’étude exemplaire pour analyser l’impact de l’IA dans les environnements professionnels. Bien qu’ancré dans l’écosystème Microsoft, les principes et observations qui en découlent s’appliquent largement à tout assistant ou brique IA capable de simplifier des processus clés, et parfois même d’automatiser des tâches complexes. Dans des environnements bureautiques, ces outils permettent d'améliorer la productivité des collaborateurs en intégrant des fonctionnalités d’assistance directement dans les outils du quotidien ; nous avons par exemple tous entendu parler de telles ou telles fonctions soudainement « assistées par l’IA », de Pierre au marketing, à Sarah à la compta en passant par Manuel et Ingrid à la logistique et aux achats. Cette approche offre des gains immédiats en termes d’efficacité opérationnelle (moins de temps pour plus de précision-complexité), notamment dans des tâches telles que la rédaction automatisée, la gestion des courriels ou encore la création de tableaux de bord interactifs, ... la liste est longue.

Les limites des solutions initiales

Malgré tout son potentiel, Copilot n’est pas exempt de limitations. Les Proofs of Concept (POC), bien qu’essentiels pour valider la faisabilité technique d’un projet, et malgré les trésors de louanges des plus enthousiastes, peinent souvent à être transformés en déploiements opérationnels à grande échelle.

Les causes principales incluent sont multiples, et incluent la plus part du temps une fragmentation des outils, une dépendance aux silos de données et une absence de stratégie intégrée pour connecter Copilot aux processus métiers complexes. Ces obstacles freinent l’industrialisation des cas d’usage et limitent leur portée dans un cadre organisationnel plus large.

Les enjeux d’une stratégie à grande échelle

Mais il n’y a point de fatalité. Pour dépasser ces limitations, il est possible de développer une approche stratégique, fondée sur une vision globale des objectifs et des besoins métiers. Cela implique de structurer les cas d’usage autour de modules technologiques modulaires et scalables.

Une telle approche permet non seulement de répondre aux besoins immédiats, mais aussi de préparer les organisations à des évolutions futures, en posant les bases d'une transition stratégique durable.

En exploitant des plateformes hyperscalers telles que Microsoft Azure, Google Cloud ou AWS, pour n’en citer que trois, les entreprises peuvent concevoir des solutions robustes, capables de s’adapter à des contextes variés tout en optimisant les coûts et les ressources.

Construire une trajectoire hyperscalable

Dans le domaine de l’intelligence artificielle, les hyperscalers (nouveau buzzword !) offrent des infrastructures robustes et adaptables qui intègrent des capacités avancées telles que les Large Language Models (LLM) et des outils d'analyse en temps réel, facilitant la création de solutions IA évolutives. Par exemple, Microsoft se distingue grâce à son partenariat stratégique avec OpenAI, renforçant ses capacités en IA avancée. Google, de son côté, propose une offre complémentaire axée sur l’optimisation des flux de données et la performance des algorithmes.

Ces plateformes permettent aux entreprises de concevoir des solutions IA à grande échelle en s’appuyant sur des ressources hautement disponibles et sécurisées.

La distinction entre ces acteurs permet aux organisations de choisir l’approche la plus adaptée à leurs besoins métiers spécifiques, qu’il s’agisse d’intégration rapide, de capacités analytiques avancées ou d’optimisation des coûts. En capitalisant sur ces capacités, les organisations peuvent accélérer le passage de concepts initiaux à des déploiements opérationnels.

On vous a perdu avec ce jargon théorique ? En fait, ce n’est pas si compliqué. Accrochez-vous, vous allez bientôt tout comprendre !

Définir la trajectoire

Une trajectoire hyperscalable repose sur le concept de Capability Pathway – une méthodologie qui structure les cas d’usage par familles de capacités modulaires. Ce cadre permet de connecter des modules technologiques complémentaires pour répondre à des besoins spécifiques.

Par exemple, un cheminement dans la gestion logistique pourrait inclure la prédiction des stocks, l’optimisation des itinéraires de livraison et l’automatisation des commandes. Chaque module technologique agit comme un bloc interconnecté dans une architecture globale, facilitant ainsi l’adaptabilité et l’évolutivité des solutions.

Les Business Apps Accélérateurs constituent un autre élément clé de l’hyperscalabilité. Ces solutions pré-packagées, construites sur des plateformes comme Microsoft Power Apps ou Azure Logic Apps, permettent de répondre rapidement à des besoins métiers spécifiques tout en garantissant une intégration fluide avec les systèmes existants.

Par exemple, une application de recommandations personnalisées pour un site e-commerce peut être déployée rapidement en combinant des modèles d’IA existants avec des connecteurs de données prêts à l’emploi. Cette approche réduit les temps de développement tout en maximisant l’efficacité opérationnelle.

En s’appuyant sur ces stratégies et outils, les entreprises peuvent construire des trajectoires hyperscalables, capables de transformer les initiatives IA en moteurs de croissance durable, à l’échelle.

Identifier les étapes

De plus, passer d’un POC à un déploiement à grande échelle nécessite une analyse approfondie des cas d’usage afin d’identifier les étapes nécessaires pour les convertir en solutions opérationnelles.

Par exemple, un cas d’usage en marketing personnalisé pourrait commencer par l’implémentation d’un moteur de recommandations dans une région pilote, suivi d’un déploiement progressif à travers d’autres régions ou segments de clientèle. Chaque étape s’appuie sur des retours d’expérience précis pour affiner et ajuster la solution.

Un autre cas d’usage pertinent se situe dans la gestion des ressources humaines. L’automatisation de la présélection des candidatures peut initialement être testée sur un périmètre restreint, comme un service spécifique, pour valider les algorithmes de scoring et garantir l’équité dans les recommandations. Une fois le modèle ajusté, il peut être étendu à l’ensemble des recrutements, réduisant le temps nécessaire au tri des candidatures tout en améliorant la diversité et la pertinence des profils sélectionnés.

Dans le domaine de la logistique, nous l’avons évoqué, un cas d’usage pourrait consister à optimiser les itinéraires de livraison à l’aide de l’IA. Un pilote peut être lancé sur une zone urbaine à forte densité pour identifier les points d’amélioration liés aux délais et aux coûts. Les données collectées permettent ensuite d’ajuster les modèles avant d’étendre le système à une couverture nationale ou internationale, améliorant ainsi significativement l’efficacité des opérations logistiques.

Optimiser les coûts et les ressources

L’une des clés du succès dans une stratégie hyperscalable est l’optimisation des ressources financières et technologiques. Cela implique une gestion rigoureuse des coûts à chaque étape du projet, de la phase initiale de prototypage jusqu’au déploiement global. Les entreprises doivent également évaluer les besoins en infrastructure et en personnel, en s’assurant que les ressources disponibles sont alignées avec les objectifs stratégiques.

Par exemple, l’utilisation de solutions cloud flexibles comme Azure peut réduire considérablement les investissements initiaux en infrastructure tout en offrant une scalabilité adaptée aux besoins croissants des entreprises.

De même, le recours à des plateformes de gestion centralisée comme Snowflake facilite la consolidation des données en temps réel, réduisant les coûts liés aux silos de données et améliorant la prise de décision stratégique.

Dans le domaine de la maintenance prédictive, des outils comme IBM Maximo permettent d’identifier et de résoudre les problèmes d’équipement avant qu’ils ne surviennent, réduisant ainsi les temps d’arrêt et les coûts opérationnels.

Par ailleurs, l’automatisation des flux de travail, avec des solutions comme UiPath, libère les équipes des tâches répétitives et chronophages, leur permettant de se concentrer sur des activités à forte valeur ajoutée.

Enfin, des plateformes comme Tableau ou Power BI fournissent des capacités de visualisation avancées, rendant les analyses complexes accessibles aux équipes non techniques et améliorant ainsi l'agilité organisationnelle.

La transition d’un POC à un déploiement à grande échelle exige donc plus qu’une simple mise en œuvre technique. Elle repose sur une planification stratégique approfondie, une maîtrise des coûts, et une capacité à aligner les ressources avec des objectifs clairs et mesurables.

Cette transition repose également sur l’utilisation judicieuse des plateformes technologiques, des outils d’automatisation et des solutions de visualisation. En structurant méthodiquement chaque étape, les organisations peuvent transformer des idées prometteuses en leviers d’innovation pérennes, posant ainsi les bases d’une transformation à grande échelle.

Au-delà de la scalabilité

L’évolution rapide des technologies d’intelligence artificielle ouvre des opportunités sans précédent, mais impose également de nouvelles attentes. Les entreprises doivent anticiper l’émergence de nouveaux paradigmes technologiques, comme l’intégration croissante de l’IA générative ou l’expansion des capacités d’automatisation dans des domaines encore sous-exploités, tels que la personnalisation avancée dans la santé ou l’optimisation en temps réel dans les chaînes logistiques.

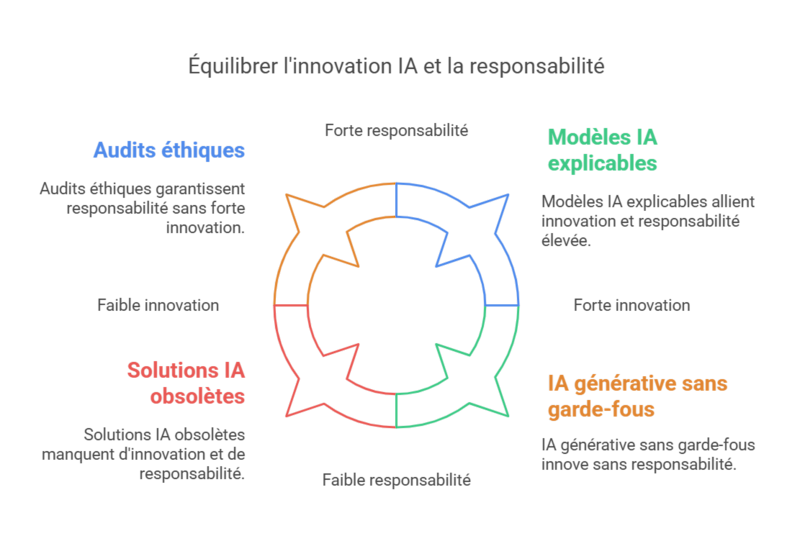

Parallèlement, des innovations comme les modèles fondés sur l’IA explicable (XAI) et l’interopérabilité étendue des systèmes promettent de réduire les risques tout en augmentant la confiance dans les décisions automatisées. Une stratégie durable repose sur la capacité à identifier les futurs besoins métiers et à ajuster les trajectoires IA en conséquence, tout en assurant une flexibilité pour s’adapter aux disruptions imprévues et aux exigences réglementaires évolutives.

La montée en puissance de l’intelligence artificielle pose également des questions fondamentales sur ses impacts sociaux et éthiques.

Les systèmes de reconnaissance faciale, par exemple, soulèvent des préoccupations majeures en matière de vie privée et de surveillance de masse, et les entreprises doivent désormais s’engager dans des pratiques responsables, en intégrant des audits éthiques et en garantissant une gouvernance claire pour éviter les dérives potentielles.

Désormais, il faut aborder des sujets tels que la transparence des algorithmes, la protection des données personnelles, et l’équité dans les prises de décision automatisées. Adopter une approche responsable signifie intégrer ces considérations dès la conception des solutions IA, en impliquant des parties prenantes variées pour assurer un équilibre entre innovation technologique et acceptabilité sociétale.

Harmoniser vision stratégique et innovation technologique

L’intelligence artificielle s’impose comme une technologie révolutionnaire, mais sa véritable valeur réside dans sa capacité à s’intégrer de manière stratégique et scalable dans les processus organisationnels. Les défis liés à l’industrialisation de l’IA, ne sauraient se résumer à la nécessité de dépasser les POC pour atteindre des déploiements robustes et efficients ; ce n’est qu’une première étape. Étape que viendront compléter outils et méthodologies permettant de structurer des trajectoires hyperscalables, tout en anticipant les évolutions futures et les enjeux éthiques.

Chez Keyrus, nous sommes convaincus que la réussite des projets d’IA repose sur l’alliance entre une innovation technologique audacieuse et une approche stratégique sur mesure. En tant que partenaire de confiance, nous accompagnons nos clients dans cette transformation en proposant des solutions adaptées à leurs besoins spécifiques, tout en assurant une vision à long terme. De la structuration des cas d’usage à leur mise en œuvre opérationnelle, nous apportons une expertise pointue pour garantir des résultats concrets et durables.

En collaborant avec Keyrus, les organisations peuvent tirer pleinement parti des occasions offertes par l’intelligence artificielle, tout en relevant les défis complexes de la scalabilité et de l’éthique.

Quelle lecture complémentaire ?

Pour encore plus de bonheur de lecture intelligente Keyrus, sur un sujet connexe nous vous conseillons : We Don't Need No Limitations, qui explore les barrières qui freinent le développement et l'intégration de l'intelligence artificielle, à travers la métaphore des murs.

S'appuyant sur la théorie des cinq murs de l'IA de Bertrand Braunschweig (confiance, consommation énergétique, sécurité des systèmes, interactions homme-machine, inhumanité des machines), il ajoute un sixième obstacle : la limitation des données d'apprentissage. Le document analyse ces barrières sous l'angle actif/passif : certaines sont intentionnellement érigées pour protéger, d'autres émergent des limites techniques. L'eBook invite à une réflexion sur la démolition consciente de ces murs pour intégrer l'IA de manière harmonieuse, équilibrée et éthique.