Crea una buena cultura de datos para empezar a cosechar los beneficios de la personalización a escala.

El Data Science permite a los departamentos de marketing consolidar y extraer información de todos sus datos (independientemente del formato), reconocer patrones en esos datos y predecir el comportamiento futuro para crear campañas de personalización a escala prácticamente en tiempo real. A continuación, aprenderás cómo tu equipo de marketing puede sacar partido de la ciencia de datos para:

Unificar los silos de datos habilitando una visión 360º de los clientes.

Proporcionar un acceso rápido y escalable a los datos soportando cargas de trabajo concurrentes.

Construir data pipelines eficientes para mejorar la velocidad de los conocimientos y reducir la complejidad.

Preparar para el futuro tu infraestructura a fin de soportar una variedad de herramientas, bibliotecas y marcos de trabajo sin necesidad de crear de nuevo una plataforma.

Integrar a los data scientists en los equipos de negocio para mejorar la exposición a los problemas empresariales del mundo real.

Atraer y retener a los mejores profesionales de data science.

Merece la Pena Invertir en la Personalización a Escala

A través de la personalización, los marketers pueden enviar contenidos y ofertas hiperpersonalizadas que tendrán más probabilidad de impulsar las compras y aumentar la fidelidad de la marca.

El 91% de los consumidores tienden a comprar a empresas que reconocen, recuerdan y proporcionan ofertas y recomendaciones relevantes.

Por ejemplo, al emplear una visión holística de los datos de los clientes, un retailer puede mostrar anuncios de ropa de running a las personas que tienen la aplicación de fitness Strava instalada en sus móviles y además muestren afinidad con los maratones, basándose en la alta probabilidad de que sean corredores. Además, los marketers pueden personalizar las recomendaciones de productos en sus páginas web y apps, lo que se traduce en una mejor experiencia del usuario.

Aunque la personalización ayuda a los profesionales del marketing a optimizar el gasto publicitario y mejorar el customer lifetime value, el tamaño de la cesta y la retención, en muchas organizaciones la personalización a escala es insostenible.

Según un informe de Adobe «2020 Digital Trends», solo el 30% de las empresas afirmó que sus plataformas tecnológicas podían combinar datos conocidos y anónimos para activar perfiles de clientes en tiempo real en todos los canales a lo largo del customer journey o recorrido del cliente.

Para resolver estos problemas, los equipos de marketing con visión de futuro están integrando herramientas y equipos de data science en sus operaciones. A continuación, veremos las mejores formas de utilizar el Data Science y el Machine Learning para lograr una visión 360 de tus clientes y ofrecer experiencias y ofertas 1:1 en tiempo real o casi real.

¿Qué es Data Science?

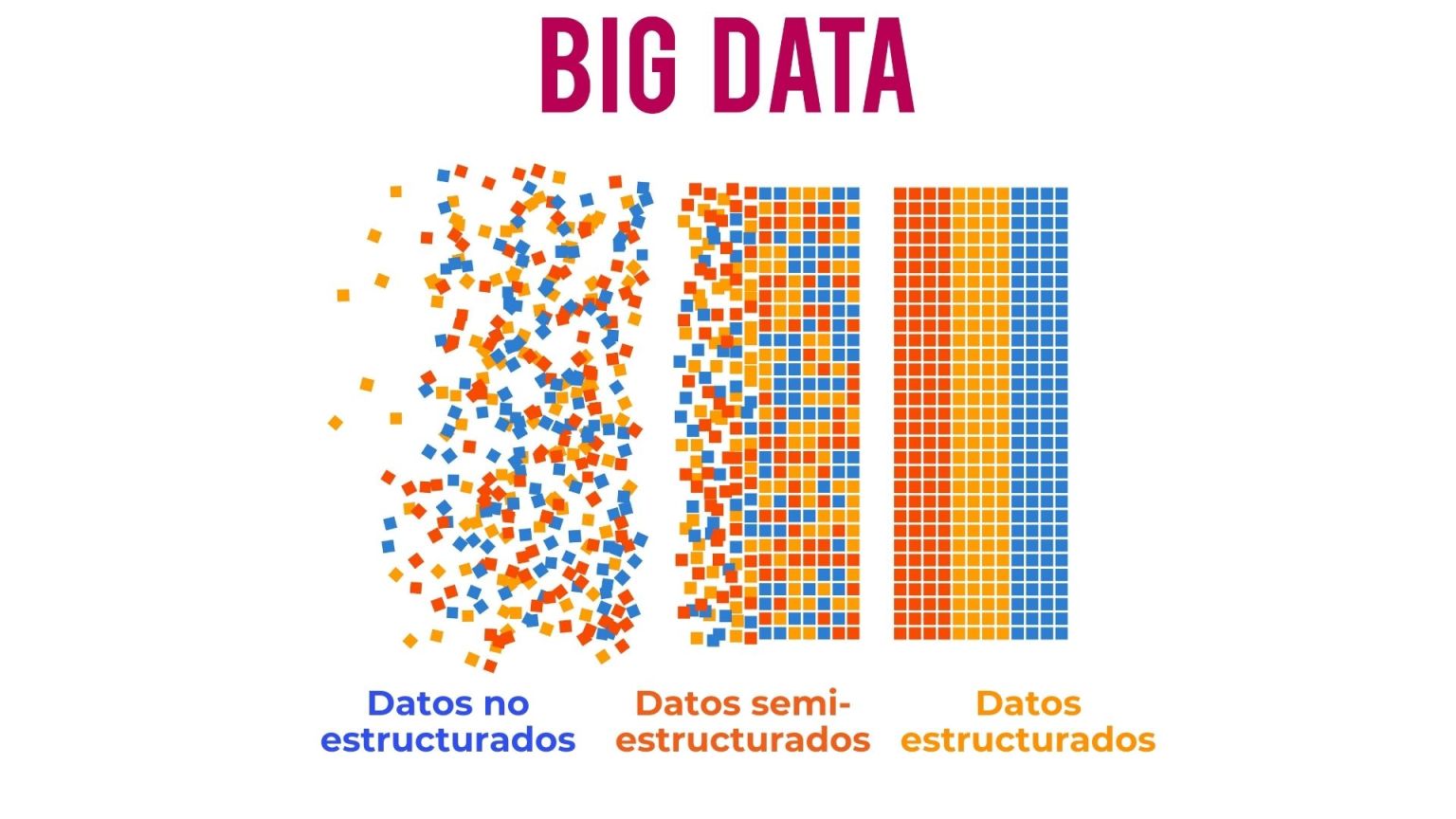

La Ciencia de los Datos o Data Science es el proceso de utilizar el aprendizaje automático y la modelización matemática para extraer conocimientos e ideas de los datos estructurados, semiestructurados y no estructurados. Una de sus principales aplicaciones consiste en reconocer patrones para predecir el comportamiento futuro.

Los datos estructurados se presentan en formatos estandarizados y, a efectos de marketing, incluyen datos de localización, historial de compras, impresiones de anuncios y entradas de CRM. Los datos semiestructurados tienen un formato estándar de columnas y cadenas, como el contenido de las reseñas o las consultas de los clientes, y los datos no estructurados no tienen un formato definido, como los archivos de audio, vídeo o imagen.

Veamos 4 ejemplos de cómo las organizaciones de marketing están utilizando Data Science para impulsar el ROI:

Segmentación de clientes: Los científicos de datos pueden agrupar a los clientes y prospects en segmentos de audiencias basándose en sus comportamientos y características relevantes. Los clientes de alto valor que compran productos o servicios frecuentemente son un segmento típico, al igual que lo son los clientes de riesgo que pueden estar en peligro de perderse. Estos segmentos deben ser tratados de forma muy diferente, y ahí es donde entran en juego los contenidos, las experiencias y las ofertas personalizadas.

Optimización de campañas en tiempo real: Al consultar los datos en un sistema de baja latencia, los profesionales del marketing pueden ver el rendimiento de las campañas en tiempo real y filtrar esa visión por cada segmento de audiencia. A partir de ahí, se pueden ajustar rápidamente el targeting y los mensajes para optimizar el rendimiento.

Modelos de atribución: Los marketers pueden optimizar el gasto de los anuncios fijando el crédito de las ventas o las conversiones que deben asignarse a cada canal de comunicación. Pueden utilizar diferentes enfoques, desde modelos que otorgan todo el crédito al primer o último touchpoint hasta otros que lo reparten entre varios puntos de contacto.

Análisis predictivo: Consiste en identificar las probabilidades de resultados futuros mediante el análisis de datos históricos. Los métodos utilizados para mejorar las recomendaciones de productos incluyen el Lookalike Modeling, que identifica a los clientes potenciales que tienen más probabilidades de convertirse en clientes de alto valor, y el Affinity Scoring Modeling, que mide los intereses de las personas en función de su historial de navegación. Gracias a la continua mejora de los modelos de aprendizaje automático, estas predicciones pueden ser cada vez más precisas.

Best Practices para integrar Data Science en tus operaciones de marketing

1) Acaba con los silos para crear una visión 360º de los clientes

Según la sexta edición del informe «State of Marketing» de Salesforce, se prevé que el número medio de fuentes de datos empleadas por los marketers aumente en un 50%, de 8 a 12, entre 2019 y 2021.

Hoy en día, las organizaciones de marketing disponen de datos de compra, datos de tráfico de su web, datos de medios de pago, datos de programas de fidelización, datos de correo electrónico y de aplicaciones móviles, y otros conjuntos de datos, que a menudo se almacenan en sistemas separados y desconectados. Este efecto de silo dificulta la obtención de la visión integrada de los clientes, que es necesaria para la personalización del marketing a escala.

La mayoría de estos conjuntos de datos residen en plataformas de terceros, lo que agrava aún más el problema. Esas plataformas únicamente ofrecen informes paquetizados con datos de su propia plataforma, por lo que los científicos de datos no pueden conectarse fácilmente a los datos en bruto y consultarlos o explorarlos de forma flexible según les convenga.

Los datos de las plataformas de terceros tampoco pueden combinarse con los datos de otros clientes. Esto hace imposible tener una visión holística de los clientes y prospects e impide ejecutar modelos de atribución multitáctil (multitouch attribution models) que repartan el crédito de las ventas y ayuden a los profesionales del marketing a optimizar su gasto.

Al consolidar los conjuntos de datos de los clientes en Data Cloud de Snowflake y en la plataforma de Snowflake, que puede soportar de forma nativa todos los tipos de datos (estructurados, semiestructurados y no estructurados) en el mismo sistema, los marketers pueden sacar más provecho de la potencia de sus herramientas de análisis. También tendrían la posibilidad de acceder a los datos y consultar la información de los clientes en tiempo real. Esto es fundamental para obtener una compresión holística y actualizada de los clientes, que a su vez es necesaria para la creación de modelos de personalización escalables.

2) Garantiza un acceso fácil y rápido a los Datos

Una vez hayan unificado sus datos, las organizaciones deberán ser capaces de soportar cargas de trabajo concurrentes. Esto es difícil en las plataformas on legacy que tienen un número fijo de servidores. Una plataforma ampliable de forma elástica, por otra parte, permite que docenas o incluso cientos de usuarios realicen cargas de trabajo de procesamiento y análisis de datos simultáneamente, incluidas las cargas de trabajo para la personalización, modelos de atribución, análisis ad hoc e informes normativos. Esto garantiza la disposición de la capacidad de computación necesaria para llevar a cabo análisis avanzados sin que se produzcan cuellos de botella en otros procesos.

Las organizaciones de marketing deben invertir en una plataforma de datos cuya capacidad pueda ampliarse de forma instantánea para ofrecer más potencia de cálculo bajo demanda, liberando a los equipos para que produzcan resultados con la mayor rapidez posible. La elasticidad instantánea elimina la necesidad de programar y realizar trabajos por lotes, de forma que los científicos de datos pueden ejecutar modelos completos y, al mismo tiempo, los usuarios no técnicos tienen la capacidad de acceder a los dashboards sin problemas.

Esto es especialmente importante para las organizaciones que invierten en la personalización, ya que se requiere una potencia de procesamiento significativa para preparar los datos, actualizar los algoritmos, regenerar las características y volver a entrenar múltiples modelos de Machine Learning.

3) Construye Data pipelines eficientes

A medida que los datos pasan de ser una simple curiosidad a una parte esencial de las operaciones, las organizaciones construyen un número cada vez mayor de data pipelines para respaldar casos de uso críticos, como la personalización y los informes normativos. Cuanto mayor son los resultados data-driven, se genera mayor valor de negocio, lo que hace que más usuarios quieran esos resultados, que a su vez promueve la construcción de más y más pipelines.

Aunque el precio de los pipelines empieza siendo bajo, puede convertirse rápidamente en un enorme centro de costes, alcanzando hasta decenas de millones de dólares al año. Esta proliferación de canales conduce a problemas de calidad y mantenimiento de los datos, así como de eficiencia y escala. Además, cuando los datos subyacentes o los formatos de datos cambian, los pipelines a menudo tienen que ser reconstruidos, generando una creciente deuda técnica.

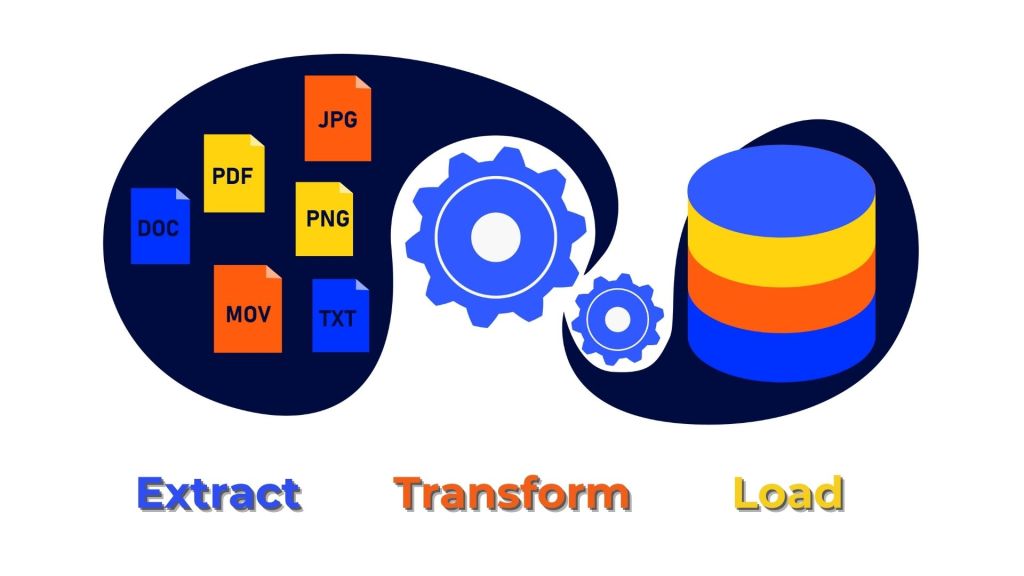

Para ayudar a romper este ciclo, las organizaciones necesitan herramientas modernas que soporten un proceso flexible de Extracción, Carga y Transformación (ELT) para sobrellevar los cambios de tipo de datos en el sistema de origen sin romperse. Por otro lado, los sistemas legacy de extracción, transformación y carga (ETL) suelen ser lentos, frágiles y caros, y rara vez satisfacen las necesidades cambiantes de toda la organización. Esto conduce a una mala experiencia del usuario y a la implantación de múltiples soluciones ETL por los diferentes equipos, provocando discrepancias en los datos y falta de confianza.

Spark sigue siendo un motor de procesamiento de datos moderno y popular para el procesamiento ETL, pero requiere trabajar con Scala o lenguajes de programación similares, lo que supone una barrera para los usuarios no técnicos. El conocimiento de SQL, en cambio, es mucho más omnipresente entre los analistas de datos y los usuarios de negocio.

Esta es otra de las razones para unirse a Data Cloud e invertir en una plataforma que potencia SQL proporcionando una forma más estandarizada de ejecutar los pipelines ETL. Como resultado, muchas más personas pueden escribir y actualizar data pipelines, y los usuarios de negocio no necesitan consultar a un ingeniero de datos cada vez que necesiten hacer pequeños cambios.

Para crear coherencia entre los casos de uso de Business Intelligence y Machine Learning, también debería considerarse disponer de un almacén de características. Esto garantiza que características como el «Customer Lifetime Value» se calculen de la misma forma para cada consulta realizada por cualquier usuario. Una vez que las características se han definido y calculado de forma centralizada, se convierten en una única fuente de verdad a la que se hace referencia en todas las consultas e informes.

4) Asegúrate de que tu infraestructura puede soportar una variedad de herramientas, bibliotecas y marcos de trabajo

La ciencia de datos está evolucionando rápidamente, y constantemente entran en el mercado startups con tecnologías avanzadas de Machine Learning. Las organizaciones de marketing no deberían encerrarse en un único conjunto de herramientas. En cambio, deberían invertir en una plataforma de datos con un amplio apoyo de la industria y la comunidad para que tanto las herramientas actuales como las futuras puedan acceder a los mismos datos.

Es importante saber que las preferencias de los usuarios suelen cambiar con el tiempo. Por ejemplo, mientras que los analistas de datos junior tienden a confiar en las herramientas de aprendizaje automático (AutoML), pueden cambiar a herramientas de escritorio como Amazon SageMaker o Zepl a medida que se amplía su conjunto de habilidades. También hay que tener en cuenta las variaciones regionales. Mientras que Python es el lenguaje principal de data science en Estados Unidos, R suele ser el lenguaje más popular en Europa.

La conclusión es que tu plataforma debe ser compatible con una variedad de herramientas, marcos y lenguajes, al tiempo que proporciona una fuente de verdad coherente para los datos.

5) Integra el Data Science en los equipos de negocio

Para crear una buena cultura de datos, es fundamental conseguir la participación de los altos cargos. El director de marketing y otros ejecutivos de la alta dirección deben comunicar de forma proactiva la inversión que se está realizando en ciencia de datos y el valor que aportará a la empresa. Lo ideal sería que estos ejecutivos desarrollaran también una estrategia global de datos que abordara los objetivos principales, la tecnología, las operaciones y el personal, y que pusieran ese documento a disposición de cualquier persona a nivel interno.

En muchos casos, es conveniente integrar a los científicos de datos dentro de los equipos de negocio en lugar de crear un equipo de datos centralizado y separado. Al vivir los problemas empresariales reales de primera mano, los data scientist estarán más alineados con sus «clientes» internos (es decir, tus equipos de branding y marketing digital). Esta forma de organizar a los equipos puede ayudarte a conseguir quick wins fácilmente.

Por ejemplo, al observar de cerca que una campaña digital nueva está teniendo un rendimiento inferior con los clientes de alto valor, el científico de datos, integrado en el equipo de marketing, puede sugerir rápidamente optimizaciones. Este tipo de recomendaciones podrían llegar días o incluso semanas más tarde si el área de data science se tratase como una función aislada, al margen de las actividades cotidianas de marketing.

Para conseguir una colaboración eficaz entre los diferentes equipos y funciones, especialmente cuando los equipos de ciencia de datos están descentralizados, también es esencial tener una única fuente de verdad centralizada en forma de conjuntos de datos limpios y cruzados que residan en la plataforma de datos de tu organización. Para evitar resultados contradictorios y problemas de confianza en los datos, los usuarios de toda la organización deben extraer comprensiones de los mismos datos.

6) Invierte en Atraer y Retener Talento TOP de Data Science

El «Data Scientist» se ha clasificado en Linkedin como uno de los principales puestos de trabajo emergentes en Estados Unidos durante tres años consecutivos, con una tasa de crecimiento anual proyectada del 37% en 2020, y no hay pruebas de que la demanda esté disminuyendo a raíz del COVID-19.

La demanda de científicos y analistas de datos sigue superando a la oferta, lo que significa que los candidatos pueden ser selectivos y los directores de contratación tienen que ser estratégicos.

La incorporación de científicos y analistas de datos puede ayudar a aumentar la entrega de modelos de personalización si tu empresa cuenta con una infraestructura de datos flexible y escalable. Pero contratar y retener a los analistas y científicos de datos puede convertirse en una batalla, incluso cuando tu empresa ofrece salarios competitivos, amplios beneficios y acuerdos de trabajo flexibles.

A pesar de lo dif�ícil que puede ser contratar a data scientists, es fundamental mantener un listón alto para el talento. Esto es especialmente importante para tus contrataciones iniciales, que serán indispensables en tus esfuerzos de adquisición de talento, aprovechando sus propias redes profesionales para reclutar a amigos y subordinados directos. Los profesionales cualificados tienden a contratar a otros con su mismo nivel de experiencia y competencia o que estén cerca de él. También es importante buscar buenos comunicadores con un historial de trabajo interfuncional con equipos no técnicos.

Las organizaciones de marketing deberían seguir el ejemplo de las grandes empresas tecnológicas y considerar programas de prácticas para ayudar a buscar y desarrollar el talento de ciencia de datos. También deberían desarrollar vías de liderazgo tecnológico y de gestión de personas para fomentar el talento a todos los niveles. Por último, para ayudar en la adquisición y la retención, deben ofrecer oportunidades de desarrollo profesional -especialmente, la oportunidad de formarse en nuevas tecnologías como PyTorch y TensorFlow que pueden ayudar a los empleados a ser mejores marketers en sus carreras más adelante.

Es importante tener en cuenta que a través del potenciamiento de una buena plataforma de datos también se pueden hacer más atractivos tus puestos de trabajo de datos y análisis para los candidatos que reciben múltiples ofertas. Una infraestructura flexible y escalable puede eliminar muchas de las tareas de «gestión de datos» que consumen mucho tiempo, liberando a los data scientist para que se centren en el trabajo de mayor impacto que les interesa.

¿Por dónde seguimos…?

La ciencia de datos ya ha transformado nuestras vidas para mejor al detectar patrones en el comportamiento diario de las personas y hacer recomendaciones y predicciones personalizadas en una variedad de aplicaciones. Mejora la industria del entretenimiento al personalizar las recomendaciones de películas y programas de televisión, y nos ayuda a llegar con seguridad y a tiempo con los sistemas de navegación en directo e informes de tráfico actualizados en el coche. Impulsa el uso de asistentes personales como Siri y Alexa, detecta fraudes con tarjetas de crédito y puede identificar automáticamente a tus amigos y familiares en las fotos. La lista de beneficios continúa.

La personalización tiene ventajas tanto para los consumidores como para las empresas que invierten en ella con el fin de mejorar sus productos y servicios. Para crear una cultura de datos exitosa que permita la personalización a escala, las organizaciones de marketing pueden:

Unificar los diferentes conjuntos de datos de clientes en una única plataforma para obtener una visión 360º de sus clientes.

Invertir en una plataforma de datos que proporcione una computación elásticamente escalable para permitir a un gran número de usuarios ejecutar una amplia variedad de cargas de trabajo concurrentes.

Construir data pipelines que apoyen un proceso de ELT flexible y resistente.

Asegurarse de que su plataforma de datos es compatible con una amplia variedad de herramientas, marcos de negocio y lenguajes, ya que las preferencias de los científicos de datos cambiarán con el tiempo.

Conseguir que los directivos se impliquen y que los científicos de datos formen parte de los equipos de marketing digital y de branding.

Mantener el listón alto a la hora de contratar científicos de datos a pesar de los retos que supone, ya que siguen siendo muy demandados.

Estas acciones representan una importante inversión en tecnología, operaciones y talento, pero el retorno de la inversión de la personalización puede ser sustancial.

Referencias: Todos los derechos reservados a Snowflake