En esta guía desmembraremos el antes y el después del intercambio y el análisis de datos en su evolución desde los sistemas legacy tradicionales hacia las nuevas plataformas de datos cloud. Descubriremos cuál es el reto fundamental al que se enfrentan los analistas, revelaremos la solución que acaba con todos los problemas y por último veremos 4 prácticas para poner en marcha el cambio desde ya. Suena bien, ¿verdad? Rápido y conciso. No te despistes que vamos a lío.

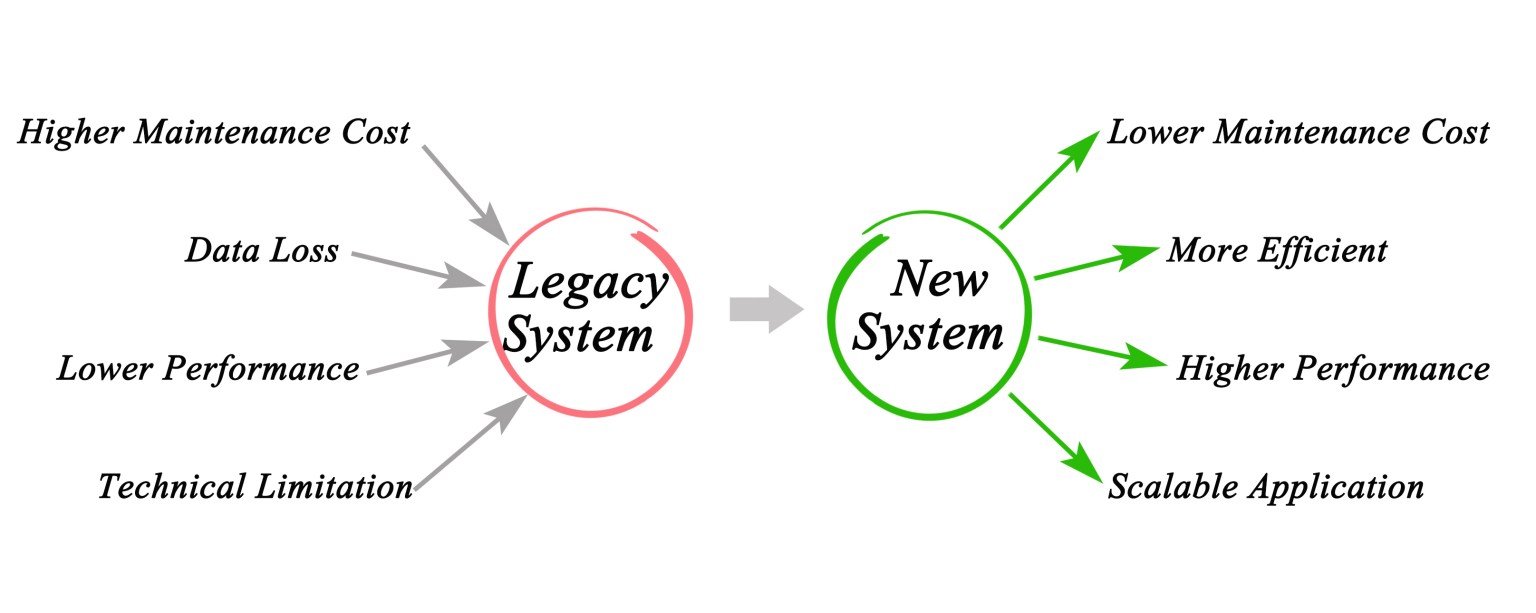

El reto: Los sistemas legacy dificultan el intercambio y el análisis de Datos

Todos los CEO´s lo tienen: usar los datos como un activo estratégico. En teoría, están en una buena posición para hacerlo. Disponen de crecientes volúmenes de datos disponibles para desarrollar una inteligencia procesable que impulse la toma de decisiones.

Sin embargo, la mayoría de las organizaciones almacenan gran parte de estos datos en sistemas legacy, algunos de los cuales tienen décadas de antigüedad. Estos sistemas crean silos de información que dificultan a las empresas poder compartir y analizar su riqueza de datos y crear una «única fuente de verdad». Sin una única fuente de verdad, la desinformación puede extenderse, dañando la confianza de los usuarios y obstaculizando la capacidad del C-level para tomar decisiones críticas.

Eso no quiere decir que no estén intentándolo. Los ingeniosos expertos en datos encontrarán herramientas y procesos para sortear esas barreras y realizar su trabajo. Pero estará lejos de ser un escenario ideal.

El propio entorno de datos también se ha vuelto más complejo. Hace unos 10 años, la aparición del Internet de las Cosas (IoT) y los nuevos conjuntos de datos generados por los sensores llevaron al desarrollo de nuevas plataformas como Hadoop y Google Big Query. Estas plataformas podían analizar muchos datos simultáneamente, pero no eran escalables.

Además, era difícil desarrollar aplicaciones para ellas porque utilizaban lenguajes específicos y requerían que los desarrolladores tuvieran conocimientos específicos. La seguridad también es un problema para las empresas, que buscan proteger sus datos sin que ello suponga un obstáculo para el intercambio de información.

La solución: una plataforma de Datos en la nube diseñada para este propósito

Actualmente los datos no siempre son fácilmente compartibles o rápidamente accesibles para quienes más los necesitan.

La clave para afrontar este reto es trasladar los datos a una plataforma de datos en la nube, en la que se pueda acceder a todos los datos de la organización, compartirlos, analizarlos y protegerlos en un solo lugar: una única versión de la verdad.

Para ello, las organizaciones deben adoptar un enfoque diferente en la gestión de datos. En un entorno tradicional legacy, el almacenamiento, la potencia de cálculo y los data pipelines están entrelazados, lo que crea silos, ya sea en los sistemas on-premise o en la nube.

Esos tres procesos deben ser completamente independientes, pero aun así deben que estar estrechamente integradas. Son los tres componentes más importantes para llevar los datos a la nube. Si voy a tomar datos de siete silos de mi organización, no quiero crear siete nuevos silos en un servidor en la nube.

En una plataforma de datos Cloud moderna, las capas de almacenamiento, computación y servicios se integran lógicamente, pero se escalan de forma infinita e independiente. Esta disociación tiene importantes ramificaciones financieras. Tradicionalmente, comprar más potencia de cálculo implicaba la adquisición de más almacenamiento, ya que están conectados. Una plataforma de datos en la nube permite a las agencias construir de manera eficiente un entorno que puede escalar un solo componente sin afectar a los demás.

Una plataforma de datos cloud es el punto intermedio entre los data lakes (donde los datos en bruto se almacenan a granel) y los data warehouses que someten los datos a un proceso de transformación, normalizándolos para que puedan consumirse fácilmente. En un repositorio de datos, las agencias pueden combinar datos semiestructurados, como el lenguaje de marcado extensible (XML) y la notación de objetos de JavaScript (JSON), con datos estructurados en un mismo lugar para permitir consultas ad hoc, y de esta forma separar el almacenamiento de la potencia de cálculo.

Las plataformas de datos preparadas para la nube son escalables, permiten acceder a más fuentes e incorporar mejores análisis, lo que conduce a una toma de decisiones más eficaz y rápida. Esto también rompe con los silos intrainstitucionales e interinstitucionales, ya que los datos almacenados en la nube pueden moverse entre los organismos. Por último, la seguridad mejora y se simplifica en un entorno cloud.

Best Practices: Habilita una única fuente de Datos

Empieza ideando una estrategia

¿Qué datos tienes en tu entorno actual y qué datos quieres trasladar? ¿Cómo vas a llevarlos a la plataforma de datos cloud, y qué harás una vez que estén ahi? ¿Cuál es la mejor forma de compartir los datos?

Hace cinco o diez años, la forma de migración más común era » lift and shift», es decir, tomar los datos tal cual y trasladarlos a su nueva ubicación, pero así solo se mueven los datos, no es realmente una migración. Hay que construir esa base para después construir las aplicaciones sobre ella. Todo se basa en el flujo de trabajo y en los casos de uso.

Traslada los datos y construye prototipos

Una vez establecida la estrategia, empieza a trasladar los datos con un enfoque gradual que priorice lo que necesitas obtener de los datos. En última instancia, el plan debe incluir la mayor cantidad posible de datos en una única fuente de verdad, ya que cuantas más versiones haya, más confusión habrá.

A continuación, hay que crear prototipos para obtener resultados rápidos que fomenten la aceptación.

Confía en la seguridad

La nube puede aumentar la seguridad de los datos, según la Estrategia Federal de Computación en la Nube, especialmente cuando las agencias trasladan o añaden controles a la propia capa de datos. Una plataforma de datos cloud debe incluir una estrategia de seguridad de varios niveles que aborde el cifrado, el control de acceso, el almacenamiento de datos y la infraestructura física, además de la supervisión y las alertas.Los analistas de datos se enfrentan a diario a tediosas tareas que retrasan o paralizan su verdadera labor de análisis y comprensión de los datos. Los sistemas legacy, por ejemplo, frenan y dificultan la tarea a los analistas.

Consigue el apoyo de los líderes y la aceptación general

Este tipo de esfuerzo requiere un cambio cultural, no solo tecnológico. Para conseguir el apoyo de los líderes, puedes utilizar un modelo de costes que muestre cómo la agencia puede hacer más por menos dinero, por ejemplo, cómo los empleados podrían ser más productivos y obtener una mayor satisfacción de su trabajo mediante el uso de datos. Para que los empleados estén de acuerdo, demuéstreles que el acceso a más datos les facilitará su trabajo. Una vez que se empieza a mostrar a la gente el valor de los datos y el valor de devolver esos datos a las personas que los crea, se inicia el cambio cultural.

La necesidad de operaciones y servicios modernos basados en datos no es nueva. Las compañías llevan tiempo trabajando para implementar la IA, la nube, el aprendizaje automático y la RPA para optimizar sus datos. El reto ha consistido en romper los silos tradicionales que dificultan el intercambio de datos dentro de las empresas y entre ellas y que, como ha demostrado la pandemia de COVID-19, son perjudiciales. Los últimos acontecimientos han demostrado que el intercambio de datos es una necesidad, no un ideal.

Las organizaciones también han tenido problemas con el sistema de registro de fuentes de datos y con reunirlos de forma útil y significativa. El enfoque más eficaz para gestionar todos esos datos y crear una única fuente de verdad es que las compañías los consoliden en una plataforma de datos en la nube que se convierta en el sistema de registro para todos.

Referencia: Todos los derechos reservados a Snowflake