¿Eres un auténtico Data Scientist?

Los científicos de datos tienen asumido que son expertos en datos, pero muchos de ellos realmente no tienen toda la información. Al igual que un Maestro Jedi sabe leer las emociones, controlar la mente de otras personas o dominar el combate con la espada láser, los verdaderos Data Scientists deben saber de estadística si no quieren ser simplemente pequeños padawans.

Esta ciencia matemática puede ser tremendamente beneficiosa para ellos, tanto para los que son nuevos en este campo como para los que llevan varios años ejerciendo. De hecho, una gran parte de los Data Scientists son antiguos estadísticos. A través de la estadística pueden hacer mucho más que un ser humano normal, convirtiéndose en auténticos maestros de la ciencia de datos capaces de aprovechar y dominar los datos de una manera más profunda y concreta, como les ocurre a los Jedis con la Fuerza.

En este artículo vamos a repasar 3 conceptos básicos de estadística que todo científico de datos ha de conocer si no quiere acabar en el lado oscuro:

1. Características estadísticas

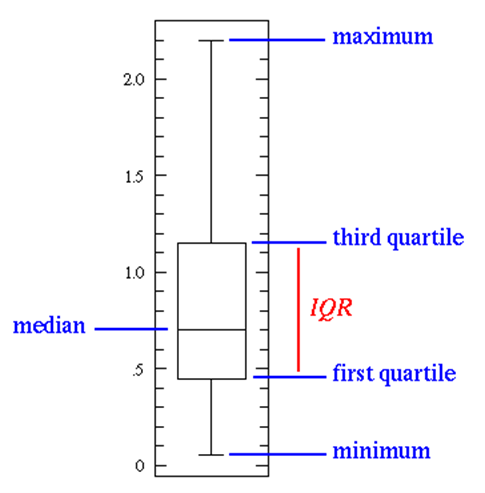

Los rasgos estadísticos (un concepto básicoenel Data Science) entran en juego durante la fase de exploración de datos e incluyen temas como el sesgo, la varianza, la media, la mediana y los percentiles. Al observar el gráfico que aparece a continuación, los valores mínimo y máximo representan los extremos superior e inferior del rango de datos.

El "primer cuartil" se utiliza para mostrar que el 25% de los puntos de datos están por debajo de ese valor, mientras que el "tercer cuartil" muestra que el 75% de los puntos de datos están por debajo de ese valor.

El diagrama de caja puede utilizarse para interpretar de manera eficaz las conclusiones sobre los datos. Por ejemplo, si el gráfico de caja es corto, muchos de los puntos de datos tendrán valores similares. Si es alto, puede indicar que los puntos de datos son diversos, ya que los valores están repartidos en un amplio rango. Si el valor de la mediana está más cerca de la parte inferior que de la superior, podemos determinar que los datos tienen valores más bajos, mientras que si está más cerca de la parte superior, sabemos que los datos tienen valores más altos. Si la mediana no cae en el centro del gráfico, puede ser un indicador de que los datos están sesgados y deben estudiarse más detenidamente antes de utilizarlos en un modelo.

2. Distribuciones de probabilidad

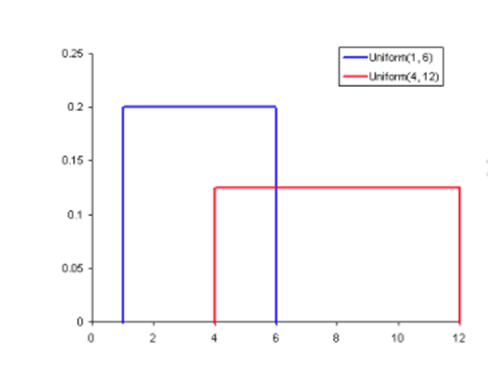

La probabilidad se refiere a la posibilidad de que un evento ocurra al azar. En la ciencia de los datos, se suele cuantificar en el rango de 0 a 1, donde 0 significa que el suceso no ocurrirá y 1 indica la certeza de que lo hará. Cuanto mayor sea la probabilidad de un suceso, mayores serán las posibilidades de que se produzca. Por tanto, una distribución de probabilidad es una función que representa la probabilidad de obtener los posibles valores que puede asumir una variable aleatoria. Se utilizan para indicar la probabilidad de un suceso o resultado.

La imagen anterior ilustra la distribución de probabilidad más básica: una distribución uniforme. Nos muestra que todos los valores entre un rango determinado son igualmente probables, mientras que todos los demás nunca pueden ocurrir.

3. Reducción de la dimensionalidad

Cuando se habla del concepto de reducción de la dimensionalidad en el ámbito de la ciencia de datos, los data scientists toman su conjunto de datos e intentan reducir el número de dimensiones que tiene, es decir, el número de variables de características.

Si cogemos un cubo para representar un conjunto de datos tridimensional con 1.000 puntos de datos y lo proyectamos en un plano bidimensional, sólo veremos una cara del cubo. Esto mejora la visualización, ya que es más fácil ver un gráfico en un espacio bidimensional que en uno tridimensional y, con los algoritmos de aprendizaje automático, se necesitan menos recursos para aprender en espacios bidimensionales que en un espacio superior.

La reducción de la dimensionalidad también puede realizarse mediante la depuración de características, que ayuda a eliminar las que no serán importantes en el análisis final. Después de revisar un conjunto de datos, por ejemplo, podemos darnos cuenta de que de 20 características, 14 de ellas tienen una alta correlación con el resultado, pero las otras seis tienen una baja correlación. Lo más sensato es eliminarlas del análisis en esa fase sin que ello repercuta negativamente en la conclusión final.

En definitiva, todo científico de datos que quiera llegar a ser un experto en su campo y obtener una ventaja competitiva, necesita familiarizarse con los conceptos estadísticos básicos, incluidos el análisis estadístico y la probabilidad. Dado que una parte importante de los proyectos de ciencia de datos y aprendizaje automático se basan en el análisis de datos, conocer estos conceptos te permitirá poder extraer ideas más potentes y tomar decisiones más informadas de tus conjuntos de datos. No te conformes con ser simplemente un pequeño padawan pudiendo llegar a ser un gran Jedi.

Todos los derechos reservados a Dataiku.